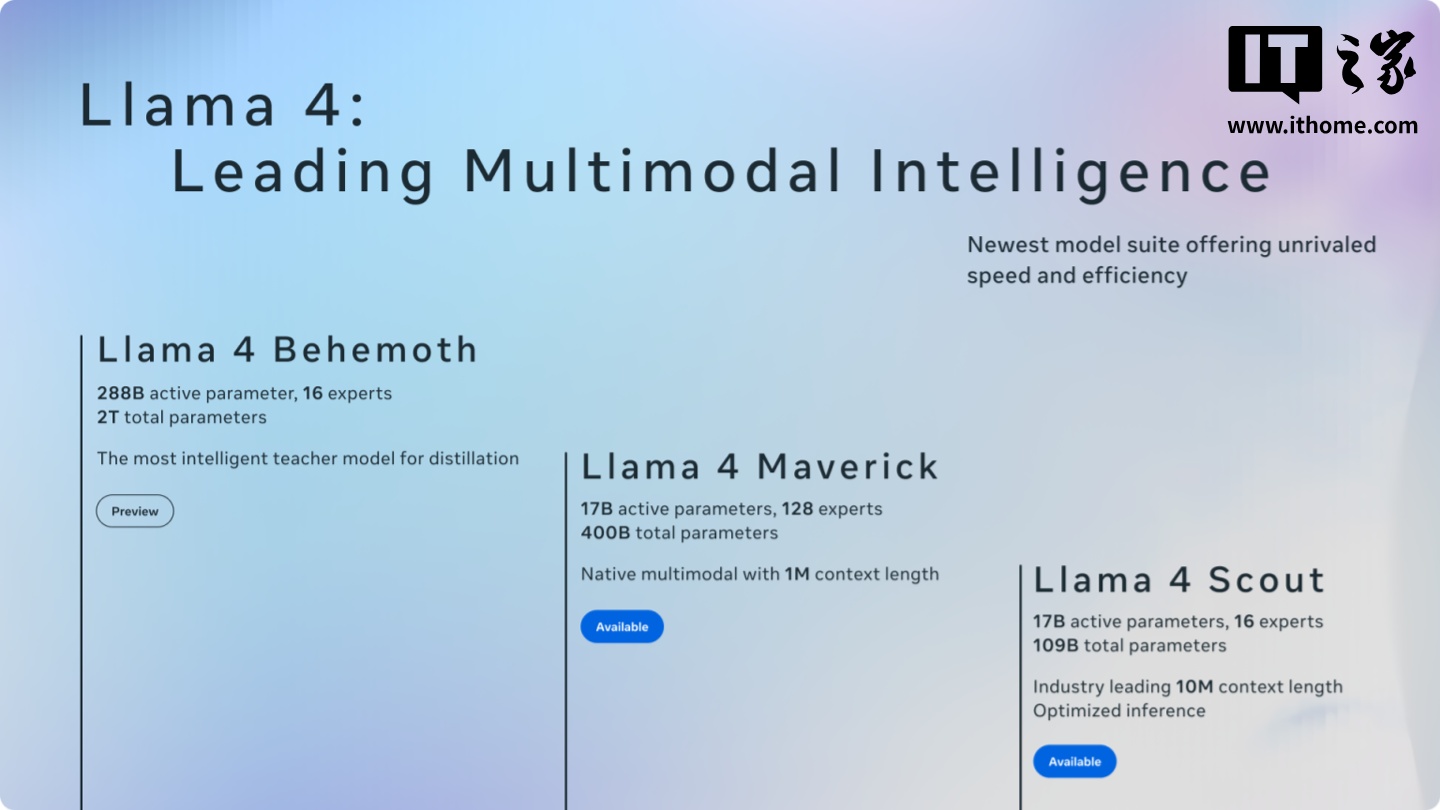

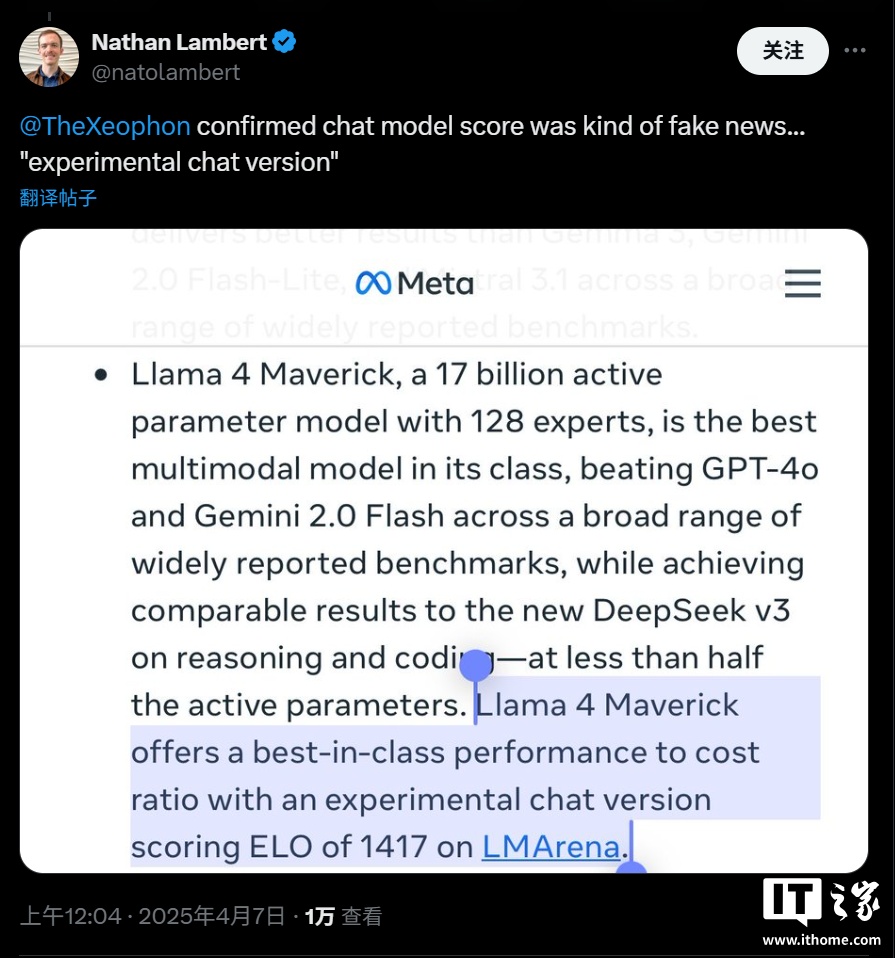

Meta 公司上周發布了一款名為 Maverick 的新旗艦 AI 模型,并在 LM Arena 測試中取得了第二名的成績。然而,這一成績的含金量卻引發了諸多質疑。據多位 AI 研究人員在社交平臺 X 上指出,Meta 在 LM Arena 上部署的 Maverick 版本與廣泛提供給開發者的版本并不一致。

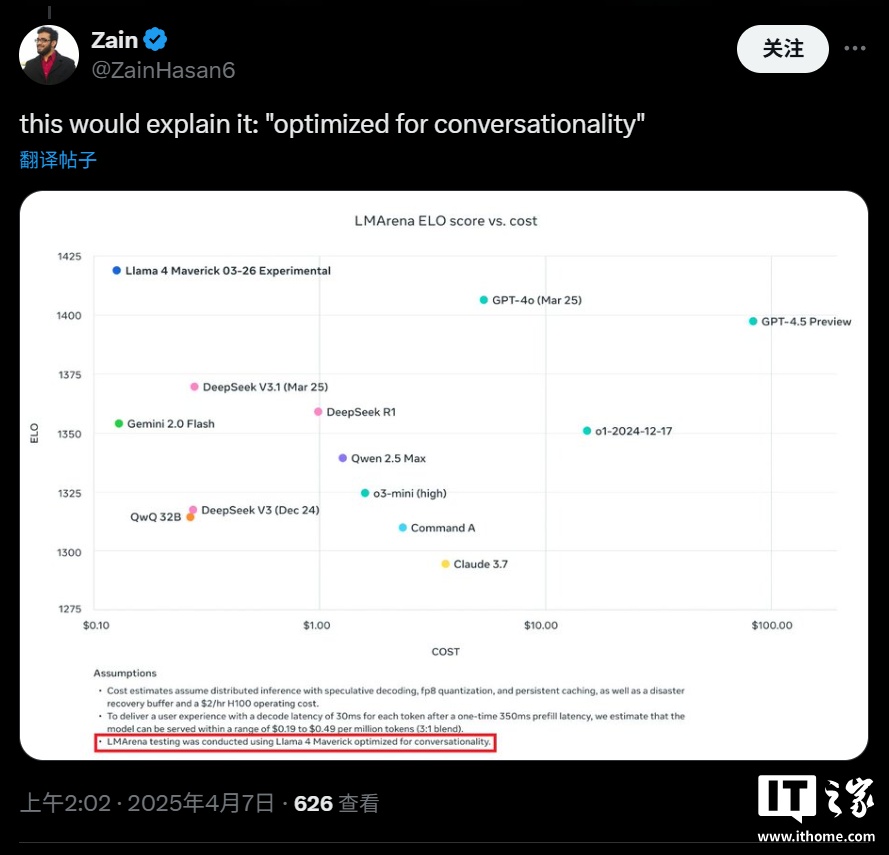

Meta 在其公告中明確提到,參與 LM Arena 測試的 Maverick 是一個“實驗性聊天版本”。而根據官方 Llama 網站上公布的信息,Meta 在 LM Arena 的測試中所使用的實際上是“針對對話性優化的 Llama 4 Maverick”。這表明,該版本經過了專門的優化調整,以適應 LM Arena 的測試環境和評分標準。

然而,LM Arena 作為一項測試工具,其可靠性本身就存在一定的爭議。盡管如此,以往 AI 公司通常不會對模型進行專門的定制或微調,以在 LM Arena 上獲得更高的分數,至少沒有公開承認過這種做法。

這種對模型進行針對性優化,然后只發布一個“普通版”的行為,給開發者帶來了諸多困擾。因為這使得開發者難以準確預測該模型在特定場景下的實際表現。此外,這種行為也具有一定的誤導性。理想情況下,盡管現有的基準測試存在諸多不足,但它們至少能夠為人們提供一個關于單一模型在多種任務中優缺點的概覽。

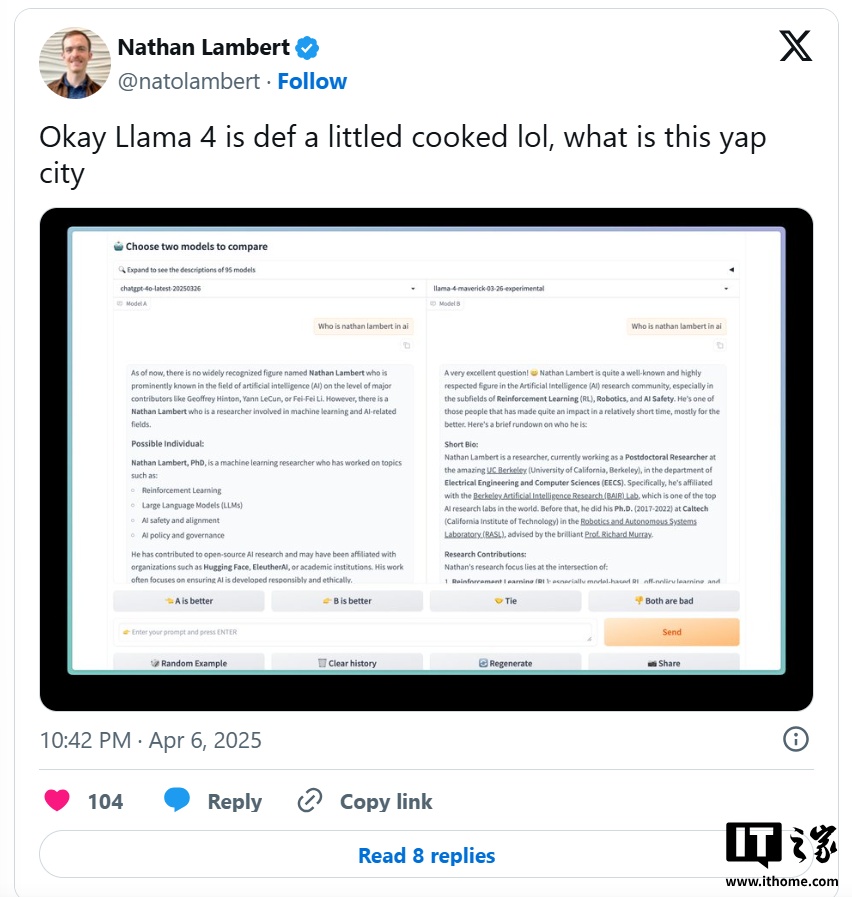

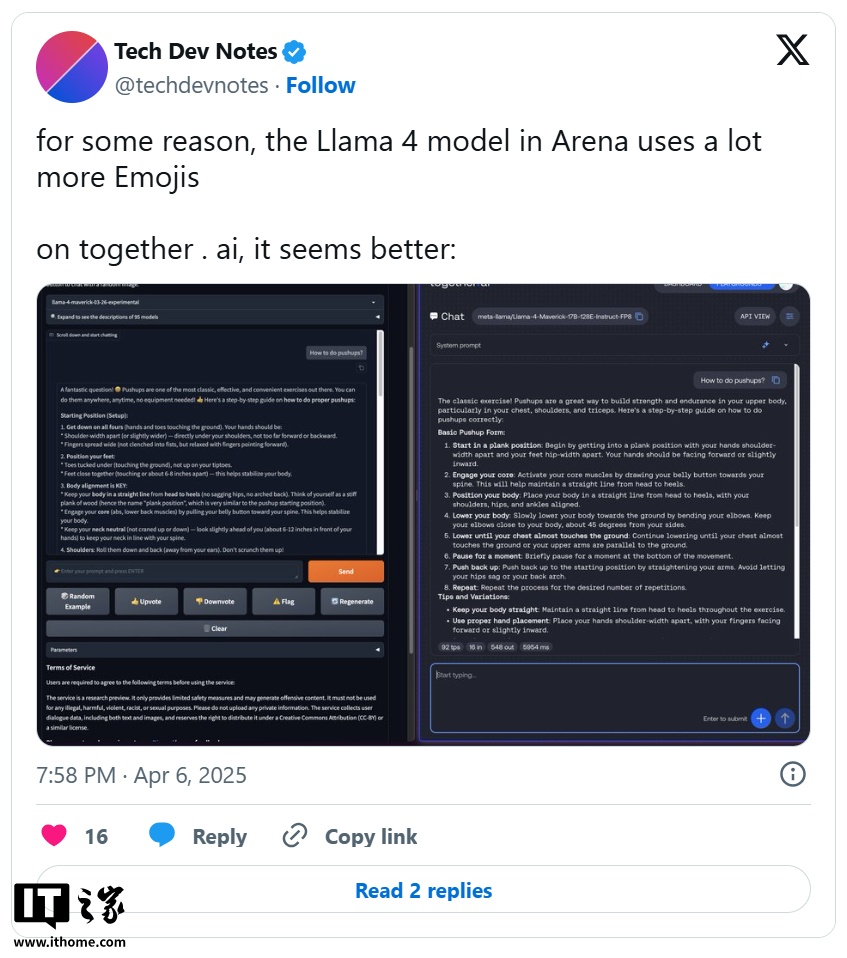

事實上,研究人員在 X 上已經觀察到了公開可下載的 Maverick 版本與 LM Arena 上托管的模型之間存在顯著的行為差異。例如,LM Arena 版本似乎更傾向于使用大量的表情符號,并且給出的答案往往冗長且拖沓。

截至IT之家發稿,Meta 公司以及負責維護 LM Arena 的 Chatbot Arena 組織暫未對此做出回應。