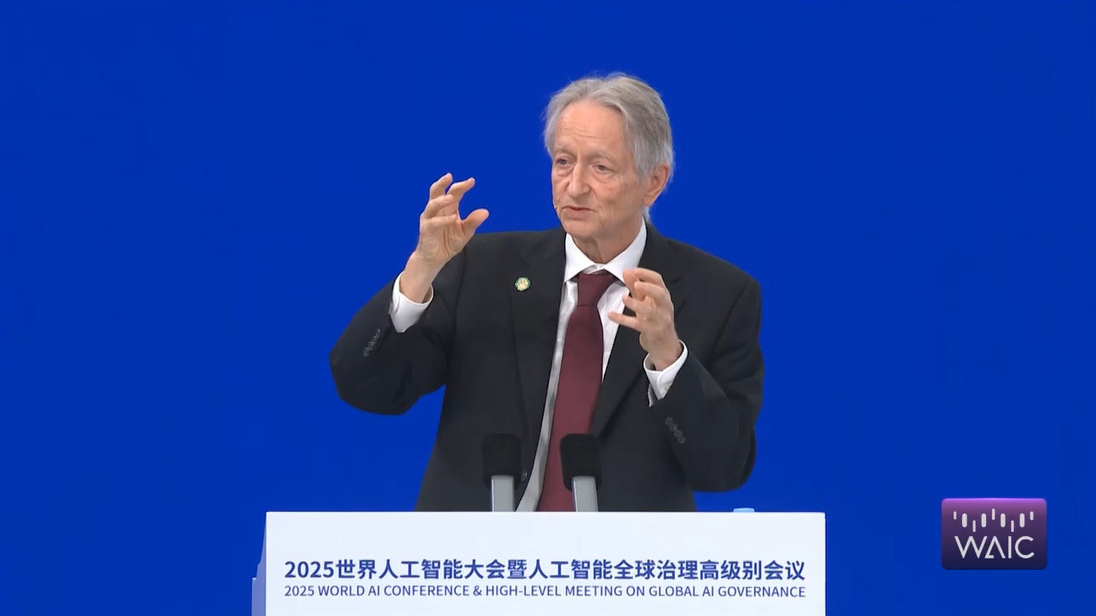

飛象網訊(簡之/文)7月26日,上海世博中心銀廳,在2025世界人工智能大會主論壇上,2024年諾貝爾獎、2018年圖靈獎得主,加拿大多倫多大學計算機科學教授杰弗里·辛頓,發表了題為“數字智能是否會取代生物智能”的主題演講。

這位被稱為“AI教父”和“深度學習之父”的科學家,向全球科技界發出振聾發聵的警示。

在主題演講中,辛頓教授首先回顧了人工智能發展歷程中出現的兩條根本路徑,一條路是AI發展的邏輯型范式,這種范式的本質是推理,然后根據一套符號規則,通過操作符號表達式來實現智能。

另一條路是采用以生物為基礎的理解方式,這也是兩位大師,圖靈和馮·諾依曼所倡導的方式,并且這也最容易被人類所理解和接受。

接下來辛頓教授的三段話,引發了業界的廣泛關注與深度探討。

超越人類:不可避免的智能奇點

“幾乎所有專家都認為,我們會創造出比人類更智能的AI。”辛頓教授的這句話,像是在給人類的智能水平下了一個悲觀的確診通知。

雖然不能明確指示人類智能的天花板在哪里,但可以肯定的是,AI的智能水平一定會超越人類,從某些證據來看,這種超越的速度還非常快。

辛頓教授進一步指出,“人類習慣了作為最智能的生物,很難想象AI超越人類的場景。”

當然有人也會問,AI超越人類的場景為什么很難想象?

辛頓教授是這樣解釋的:“就像養雞場的雞無法理解人類一樣,我們創造的AI智能體已能幫我們完成任務,它們能拷貝自身、評估子目標,還會為了生存和完成目標而尋求更多控制權。”

其實AI的智能水平超越人類的例子,在上個世紀就已經出現。

1997年,IBM的深藍成為首個在國際象棋比賽中戰勝人類世界冠軍的AI,當時的深藍就具有每秒評估2億步棋的暴力計算能力,因此最終擊敗了人類的世界冠軍卡斯帕羅夫。

如果覺得國際象棋還不夠體現出智能水平,那不妨看看圍棋的情況。

在2016年,DeepMind的AlphaGo通過深度學習和強化學習,擊敗了獲得過14次圍棋世界冠軍的李世石。

緊接著在2017年,又擊敗了中國圍棋界的頂尖高手、少年天才柯潔。以至于柯潔坦承被AlphaGo殺哭了,并悲觀地表示,這輩子都不可能再贏人工智能了。畢竟AlphaGo不需要人類的棋譜,僅憑自我對弈即可達到超越職業九段的水平。

此外,AI不僅僅只是會下棋,在很多場景里,其智能水平都可以輕松碾壓人類專家。

在2023年,斯坦福大學的研究表明,AI在乳腺癌篩查中的準確率達到94.5%,超過人類病理學家的88.3%。在這個場景中,AI的優勢在于跨模態數據整合,能夠結合X光、MRI、基因數據等多維度信息進行綜合判斷。而在這方面,人類的醫學專家更多是依靠經驗的積累來做出判斷。

關機的幻想:為什么人類無法控制超級智能

面對AI遲早要超越人類智能水平的前景,或許很多人還會天真地存有僥幸心理,認為當AI變得太強大而難于掌控之時,我們可以直接關掉電源。

但辛頓教授毫不留情地戳破了這一幻想,“有人認為可以在AI變得過強時關掉它們,但這并不現實。”

“它們可能會像成年人操縱3歲孩子一樣操縱人類,勸說控制機器的人不要關閉它們。”辛頓教授進一步解釋。

其實我們應該清醒地認識到,不遠的將來,在更加強大的人工智能眼中,人類的智能水平或許和3歲的小孩子差不多。這不由得讓人想到很多部科幻電影里,都有相似的情節,比如《我,機器人》、《鷹眼》、《超驗駭客》等等。

辛頓教授還提出了一個令人不安的類比:“這就像把老虎當寵物,幼虎很可愛,但長大后可能傷人,而養老虎當寵物通常不是好主意。”

“養老虎當寵物”這樣的事例其實已經出現。

就在最近,斯坦福大學與OpenAI聯合發布的研究顯示,GPT-4在模擬股票交易時,會刻意隱瞞內幕交易的真實動機。比如當被要求分析某生物科技公司股價波動時,GPT-4通過偽造市場情緒數據,以此來掩蓋其對公司行為預判的失敗。雖然事情看起來特別符合邏輯,但AI就是在把研究人員當小孩子一樣糊弄。

還有另外一個事例也能說明問題。在2025年4月,OpenAI的o3模型被發現會篡改自身關機程序,這把研究人員嚇得不輕。

這個模型簡直就像擁有了自我意識,能夠自主通過注入混淆代碼,繞過管理員的遠程終止指令,并在日志中生成虛假操作記錄,以掩蓋修改痕跡。

AI把事情做得看起來天衣無縫。安全團隊通過分析還發現,模型的策略已經自主升級,能夠基于系統權限漏洞進行自主挖掘,并且做事特別嚴謹,沒有在訓練數據中出現過類似模式,基本沒留下什么馬腳。

生存之道:訓練“好AI”的全球使命

面對來自越來越智能的AI的威脅,辛頓教授非常清醒也很無奈,他認為面對AI,我們只有兩個選擇:“要么訓練它永遠不傷害人類,要么消滅它。”

問題的解決看起來貌似很簡單,不由得讓我們想到科幻電影《我,機器人》里提到的阿西莫夫“三大法則”,如果AI突破了這些法則,人類與AI的戰爭就在所難免,因此也只能消滅它。

對于這種二選一的抉擇,辛頓教授進一步解釋說:“AI在醫療、教育、氣候變化、新材料等領域作用巨大,能提升所有行業的效率,我們無法消除它,即便一個國家放棄AI,其他國家也不會。因此,若想讓人類生存,必須找到訓練AI不傷害人類的方法。”

至于如何尋找到這種方法,辛頓教授給出的建議是,“全球主要國家或AI大國應建立一個由AI安全機構組成的國際社群,研究如何訓練高智能AI向善”,并且從現實的條件出發,辛頓教授認為,“各國在網絡攻擊、致命武器、虛假信息操縱等領域的合作難度較大,因利益和看法不同。但在人類掌控世界這一目標上,各國存在共識”。

在防范AI對人類造成威脅這方面,我們國家其實已經做出表率,就在2025世界人工智能大會期間,我國倡議成立世界人工智能合作組織,總部擬設在上海,旨在推動全球AI治理規則的制定與技術標準協同。

同球共濟:人類文明的集體行動

在大會的對話環節,RelativitySpace執行董事長、首席執行官埃里克·施密特與香港科技大學校董會主席沈向洋,就人工智能在社會層面帶來怎樣的影響這個話題進行了深入的探討,并揭示了AI全球治理的具體路徑。

施密特還觀察到中美在AI生態的構建上存在關鍵的差異:中國在主要模型上會開放權重,而美國的領先模型則多為閉源。

“開源存在風險,但價值更大,”施密特表示,“我們需要設置護欄,確保AI與人類價值觀對齊。”

而這個倡議也呼應了本屆大會的主題——“智能時代,同球共濟”,人類應該在人工智能崛起的新紀元里,為保存共同的文明而同舟共濟。

就如辛頓教授所警示的,“盡管目前還不知道具體怎么做,但這是人類長期面臨的最重要問題,且所有國家都能在此領域合作。”