2025 年 8 月 4 日,全球權威的 AI 性能基準評測組織 MLCommons® 正式發布最新一輪 MLPerf® Storage v2.0 基準測試結果。來自中國的存儲廠商焱融科技在此次測試中表現突出,其全閃存儲一體機 F9000X 不僅在全部模型測試中性能領先,更以三節點存儲集群 513GB/s 的總帶寬刷新 3D-Unet 模型測試的紀錄,登頂 MLPerf 全球性能榜單。

MLPerf Storage:AI 存儲性能的黃金衡量標準

MLCommons 作為全球人工智能工程聯盟,始終致力于規范 AI 技術的準確性、安全性、速度與效率評估,推動 AI 系統性能優化,其權威性得到全球業界廣泛認可。而 MLPerf Storage Benchmark 作為該聯盟專為 AI 場景打造的存儲基準測試,通過模擬真實 AI 訓練中的 I/O 操作,精準衡量存儲系統向 GPU 輸送訓練數據的速度與能力。

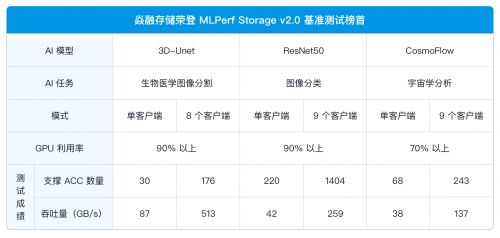

此次發布的 MLPerf Storage v2.0,在 v1.0 基礎上進一步升級:除保留 3D-Unet、ResNet50、CosmoFlow 三大訓練模型外,新增 Checkpoint 工作負載,更全面覆蓋訓練中斷點恢復、模型存檔等實際場景。為確保結果的嚴謹性與公正性,v2.0 要求每項基準測試必須多次重復執行(訓練任務 5 次、Checkpoint 任務 10 次),且全程連續運行無失敗,同步提交完整測試日志,最終結果取多次運行的平均值 —— 這一系列嚴格規范,使其成為業界衡量 AI 存儲性能時最具參考價值的權威標準。

焱融全閃刷新全球紀錄 最小規模集群性能第一

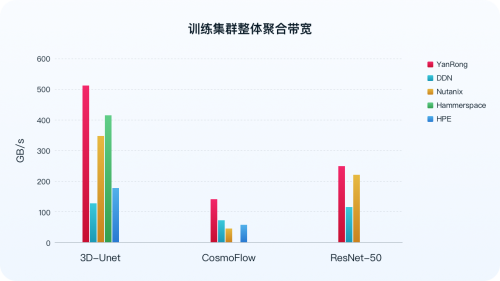

MLPerf Storage 基準測試既支持單個計算節點(客戶端)運行多個 ACC(GPU 加速器)的模型測試,也適配分布式訓練集群場景 —— 通過多客戶端模擬真實數據并行訪問存儲集群,充分覆蓋從單節點到分布式集群的全場景 AI 工作負載。其最關鍵的衡量標準,是在保證高性能 GPU 利用率(3D-Unet 與 ResNet50 模型下為 90%,CosmoFlow 模型下為 70%)的前提下,存儲系統所能實現的聚合帶寬。這項指標是衡量存儲系統實際能力的核心,直接體現其在 AI 訓練過程中是否能夠充分“喂飽”計算資源,避免造成 GPU 空閑浪費。

最新測試結果顯示,在 3D-Unet、ResNet50 以及 CosmoFlow 所有模型的測試場景下,于通用硬件環境中,針對分布式存儲的最小規模集群,即三節點存儲集群,焱融全閃 F9000X 在全球知名分布式存儲廠商中脫穎而出,集群總帶寬等關鍵指標位列全球第一。尤其是在 3D-Unet 模型測試中,集群帶寬達到 513 GB/s ,為迄今已公布結果中的最高值。

數據來源:MLCommns 官方 https://mlcommons.org/benchmarks/storage/

除分布式場景外,在單客戶端測試中,焱融全閃 F9000X 同樣展現出優異性能,進一步驗證了其在不同部署規模下的強勁數據處理能力。

此外,在新增的 Checkpoint 工作負載測試中,針對 Llama3-70B 模型場景,通過部署 8 個客戶端模擬并發請求、搭配 64 個模擬 GPU 環境,實現 221 GB/s 讀取帶寬與 79 GB/s 寫入帶寬的高性能表現。這種穩定且高效的帶寬支撐能力,能夠精準保障 Checkpoint 文件在模型訓練全流程中實現秒級極速讀寫,從底層存儲層面為 AI 訓練任務的斷點續訓連續性與模型訓練穩定性筑牢技術根基,助力企業從容應對大規模模型訓練的嚴苛存儲需求。

焱融存儲 MLPerf 測試表現背后:技術積淀與生態協同是關鍵

據了解,焱融存儲去年便參與了 MLPerf Storage v1.0 基準測試,并以出色成績從全球知名存儲廠商中強勢突圍。焱融存儲之所以能在 MLPerf 存儲基準測試中持續取得優異成績,核心在于其長期深耕 AI 大模型訓練與推理等核心場景的技術積累:一方面,通過長期深耕大模型訓練與推理等核心場景,深度理解 AI 工作負載特性;另一方面,從架構設計到軟硬件全技術棧,持續推進系統性創新與優化,構建起應對高性能負載的核心能力。

與此同時,焱融也與 NVIDIA、Intel、新華三(H3C)、憶恒創源(Memblaze)、大普微(DapuStor)等上下游生態伙伴展開深度協同,在網絡、芯片、服務器、SSD 等關鍵環節緊密合作,實現軟硬件的深度適配與極致優化,有效保障系統在 AI 基礎設施全鏈路中的高效穩定運行。

公開資料顯示,焱融全閃存儲基于其自研的高性能分布式文件系統 YRCloudFile,通過多項關鍵技術實現性能突破:

采用自研 Multi-Channel 網絡帶寬聚合技術,可整合多張 InfiniBand/RoCE 網卡性能,在大 IO 場景下充分釋放硬件潛力,支撐超高速數據傳輸;

系統具備負載感知能力,可根據壓力智能切換中斷與輪詢模式,有效提升 IOPS 性能;

在 IO 模型層面,通過異步非阻塞設計減少上下文切換、增強并行處理能力,并通過處理器核心資源的高效分配,降低線程調度開銷,支撐高并發數據處理的同時,充分發揮 NVMe SSD 的性能優勢;

針對大規模 GPU 集群易出現的網絡擁塞問題,專項優化傳輸機制,保障數據傳輸的高效與穩定。

隨著大模型向千億、萬億參數演進,存儲作為底層支撐的性能要求持續提升。此次焱融科技在 MLPerf Storage v2.0 中的表現,不僅印證了中國存儲廠商的技術實力,也為 AI 基礎設施的性能優化提供了可參考的實踐路徑。業內預計,未來存儲系統的高帶寬、低延遲能力依然是 AI 大模型廣泛落地的關鍵競爭力之一。